Notre suite de produits

Nos Solutions Tout-en un Clés en Main

Pi-search

Votre moteur de recherche intelligent

Notre technologie d’indexation multi-format analyse tous types de documents pour créer une base de connaissance unifiée. La protection des données est assurée nottament par une option de purge automatique, avec option d’export manuel. Les analytics intégrés permettent un suivi précis des usages pour une optimisation continue.

Secure LLM

L’assistant IA personnalisable

Interface intuitive permettant une configuration en quelques minutes, sans compétences techniques. Gestion fine des autorisations & SSO et intégration native avec vos outils existants.

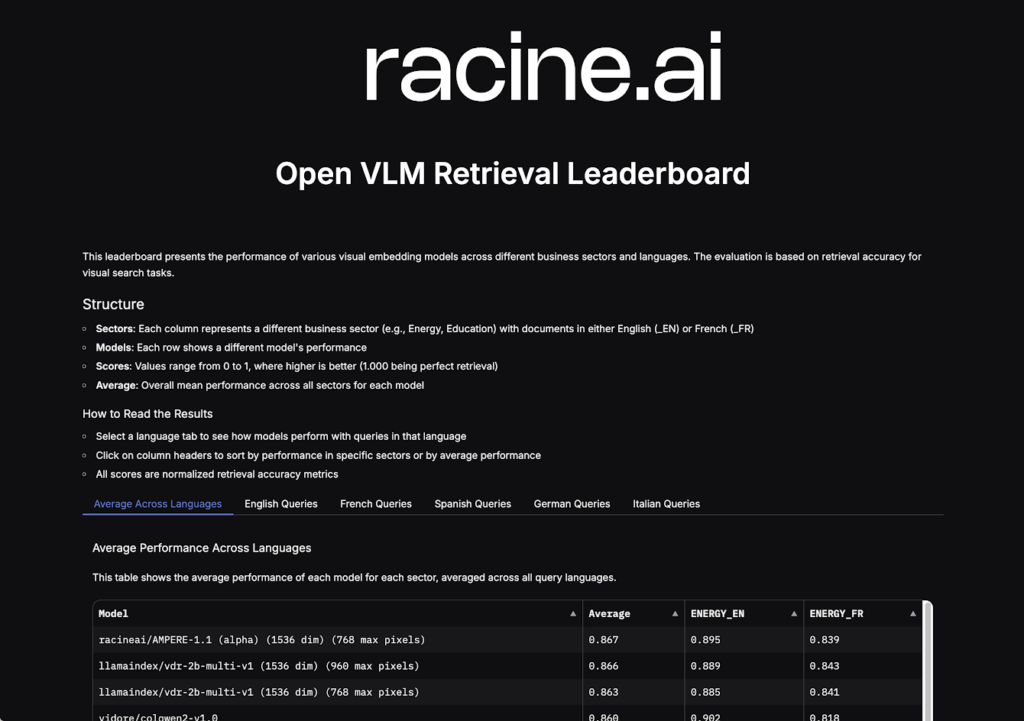

Custom Models

L’expertise des modèles spécialisés

Notre expertise en développement de modèles sur mesure nous permet d’adapter nos solutions à chaque secteur. Notre modèle phare « Le Triomphant » a atteint la première place mondiale des LLMs open source sur Hugging Face en mai 2024.

Ces évaluations nous permettent d’affiner continuellement nos architectures et d’optimiser les performances selon les besoins spécifiques de chaque industrie.

| Déploiement | 48 heures |

| Réduction des coûts* | 50% par utilisateur |

| Type de recherche | Internet & Documentaire |

| Secteurs couverts (à date) | 5 |

*En optimisant l’usage des LLMs par typologie de cas d’usage, par rapport aux abonnements standard du marché (20-30 €/mois).

FAQ

Qu’est-ce que Pi-search ?

Pi-search développe un moteur de recherche interne nouvelle génération combinant trois éléments essentiels : une indexation intelligente adaptée aux différents types de documents d’entreprise, un système de recherche sémantique avancé, et une gestion sophistiquée des bases de connaissance. L’objectif est d’optimiser l’accès à l’information tout en garantissant une exploitation efficace des connaissances d’entreprise.

Comment Pi-search peut-il résoudre les problèmes de recherche d’information dans mon entreprise ?

Imaginez pouvoir retrouver instantanément n’importe quelle information dans l’ensemble de vos documents d’entreprise, même si vous ne connaissez pas les mots exacts à chercher. Pi-search va au-delà de la simple recherche par mots-clés : il comprend le contexte, analyse les images et graphiques, et peut même faire des connexions entre différents documents. C’est comme avoir un expert qui connaîtrait tous vos documents et pourrait instantanément trouver l’information pertinente.

Pourquoi ai-je besoin d’un Secure LLM dans mon entreprise ?

Le Secure LLM est conçu pour les entreprises qui veulent bénéficier de l’IA conversationnelle sans compromettre leur sécurité. Il combine les capacités avancées des LLMs avec un contrôle strict des données. Par exemple, si un employé pose une question impliquant des données sensibles, l’agent utilisera automatiquement un modèle on-premise plutôt qu’un modèle cloud, tout en garantissant une expérience utilisateur fluide.

Qu’est-ce qu‘un routeur ?

L’une des particularité de Racine réside dans son approche « smart routing » : plutôt que d’utiliser un seul modèle pour toutes les tâches, RACINE.AI sélectionne automatiquement le modèle le plus adapté selon la complexité de la demande. Cela permet d’optimiser les coûts (en utilisant des modèles plus légers pour les tâches simples) tout en garantissant la performance (en mobilisant les modèles plus puissants quand nécessaire).

En quoi les modèles spécialisés peuvent ils apporter de la valeur à mon secteur d’activité ?

Les modèles généralistes sont comme des couteaux suisses : ils font tout, mais pas toujours de manière optimale. Nos modèles spécialisés sont entraînés spécifiquement sur votre secteur d’activité, avec son vocabulaire, ses normes et ses spécificités. Par exemple, un modèle spécialisé en géotechnie comprendra naturellement des termes techniques qu’un modèle généraliste pourrait mal interpréter.

Quelle est la différence entre un agent conversationnel classique et votre Secure LLM ?

Un agent conversationnel classique utilise généralement un seul modèle et traite toutes les demandes de la même manière. Notre Secure LLM adapte dynamiquement son comportement : il peut utiliser différents modèles selon la sensibilité des données, gérer finement les autorisations, et garantir la traçabilité des échanges. C’est comme avoir un assistant qui s’adapte automatiquement au niveau de confidentialité requis.

Comment démarrer l’implémentation de ces solutions dans mon entreprise ?

L’implémentation suit une approche progressive : nous commençons par identifier vos besoins spécifiques, puis nous déployons les solutions de manière modulaire. Par exemple, vous pouvez commencer avec Pi-search pour organiser vos connaissances, puis ajouter progressivement le Secure LLM pour automatiser certaines tâches.